L’utilizzo dell’intelligenza artificiale nell’analisi dei dati al CERN

Di Iulia Marasescu

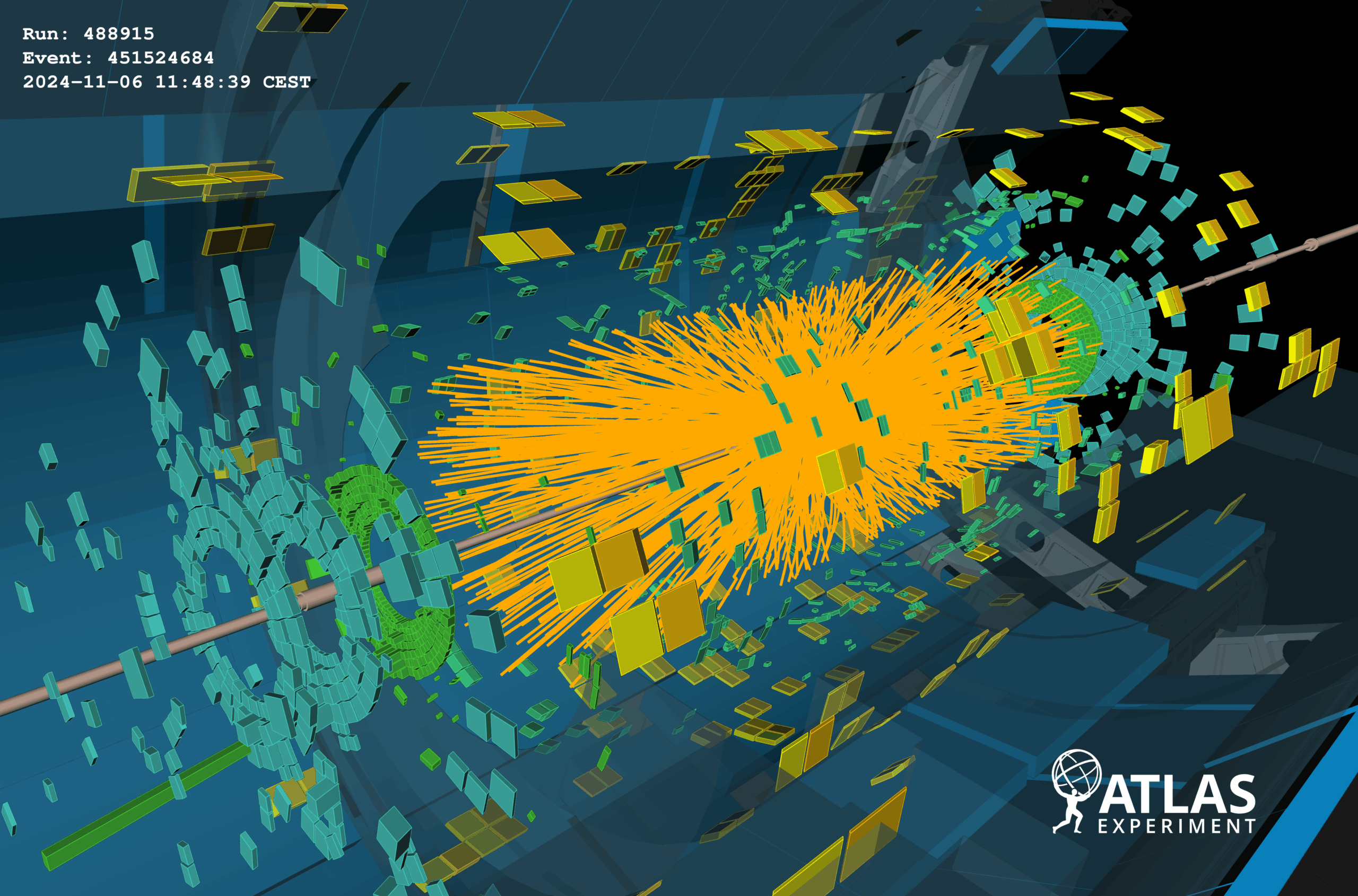

Uno degli esempi più eclatanti dell’utilizzo dell’intelligenza artificiale nell’analisi di importanti moli di dati è l’esperimento più grande al mondo, ovvero il Large Hadron Collider (LHC) del CERN. Nel LHC sono presenti quattro esperimenti separati in cui vengono fatti scontrare dei pacchetti di protoni ad altissime velocità al fine di ottenere abbastanza energia per “romperli” e ricavare le cosiddette particelle elementari, che rappresentano i tasselli più piccoli della materia. L’obiettivo è quello di studiare a fondo queste particelle per conoscerne le proprietà e scoprirne di nuove.

Ogni collisione produce 1 MB (106 byte) di dati, che non è un peso eccessivo, ma ogni secondo avvengono 600 milioni di collisioni, arrivando ad un peso complessivo di 1 PB (1015 byte) al secondo. L’enorme quantità di dati prodotti deve essere in qualche modo filtrata, poiché con le tecnologie attuali non è possibile conservare così tante informazioni; per questo motivo, è adoperato un sistema a tre livelli che permette di salvare solo i dati più significativi e scartare quelli inutili:

- il primo livello seleziona le collisioni con alti depositi di energia;

- il secondo livello sfrutta un algoritmo per fare un’analisi essenziale dei dati;

- il terzo livello utilizza un altro algoritmo per ricostruire in modo rudimentale la collisione.

Solo le collisioni che superano questi tre filtri vengono salvate per l’analisi manuale dei dati. Si passa, quindi, ad avere solamente 200 MB al secondo, che rappresenta comunque un’importante mole di dati che impiega enormi quantità di spazio (il CERN occupa annualmente circa 25 PB di spazio all’anno).

La grande energia prodotta durante le collisioni può convertirsi in nuove ed ignote particelle, per poi decadere rapidamente nelle forme più comuni della materia. Il fatto che la vita media di queste particelle sia così breve e le loro tracce così esigue, rappresenta una vera e propria sfida per gli scienziati, che devono analizzare migliaia (se non milioni) di collisioni per trovarle.

È proprio a questo punto che entra in gioco l’intelligenza artificiale. Negli esperimenti ATLAS e CMS, gli scienziati si occupano di allenare i sistemi di machine learning non supervisionato* con i jet (che sono le “scie” di dati che un rivelatore raccoglie al passaggio di un corpo e che permettono ai fisici di identificarlo) di particelle note al fine di scartare gli eventi più comuni e prevedibili e rilevare anomalie che potrebbero essere generate da particelle ancora ignote e quindi portare a delle nuove scoperte.

In particolare, le macchine utilizzate per il CMS sono state addestrate in modi diversi, rivelandosi sensibili a differenti tipi di anomalie e particelle: nessun modello, quindi, può essere ritenuto superiore agli altri. Inoltre, grazie alla loro varietà, aumenta anche la ricettività e ciò rende possibile rilevare una maggiore quantità di particelle rispetto ai tradizionali metodi di analisi dei dati.

*Machine learning non supervisionato: i dati sottoposti a questi modelli non hanno alcun tipo di indicatore o etichetta, lasciando che sia l’algoritmo stesso a trovare dei pattern nascosti senza l’intervento umano. Vengono utilizzati per raggruppare dati che non presentano nessuna etichetta in base a somiglianze, trovare relazioni nascoste tra le variabili o ridurre il peso di un’informazione senza comprometterne il contenuto.